Vad är AI Detectors?

AI Detectors är verktyg och teknologier som används för att identifiera om en text, bild eller annan typ av innehåll är genererad av artificiell intelligens (AI). Dessa detektorer analyserar specifika mönster och egenskaper i innehållet som skiljer sig från det som är skapat av människor. Målet är att kunna skilja mellan mänskligt och AI-genererat innehåll med hög noggrannhet.

Varför är de viktiga?

AI Detectors spelar en kritisk roll i flera sammanhang:

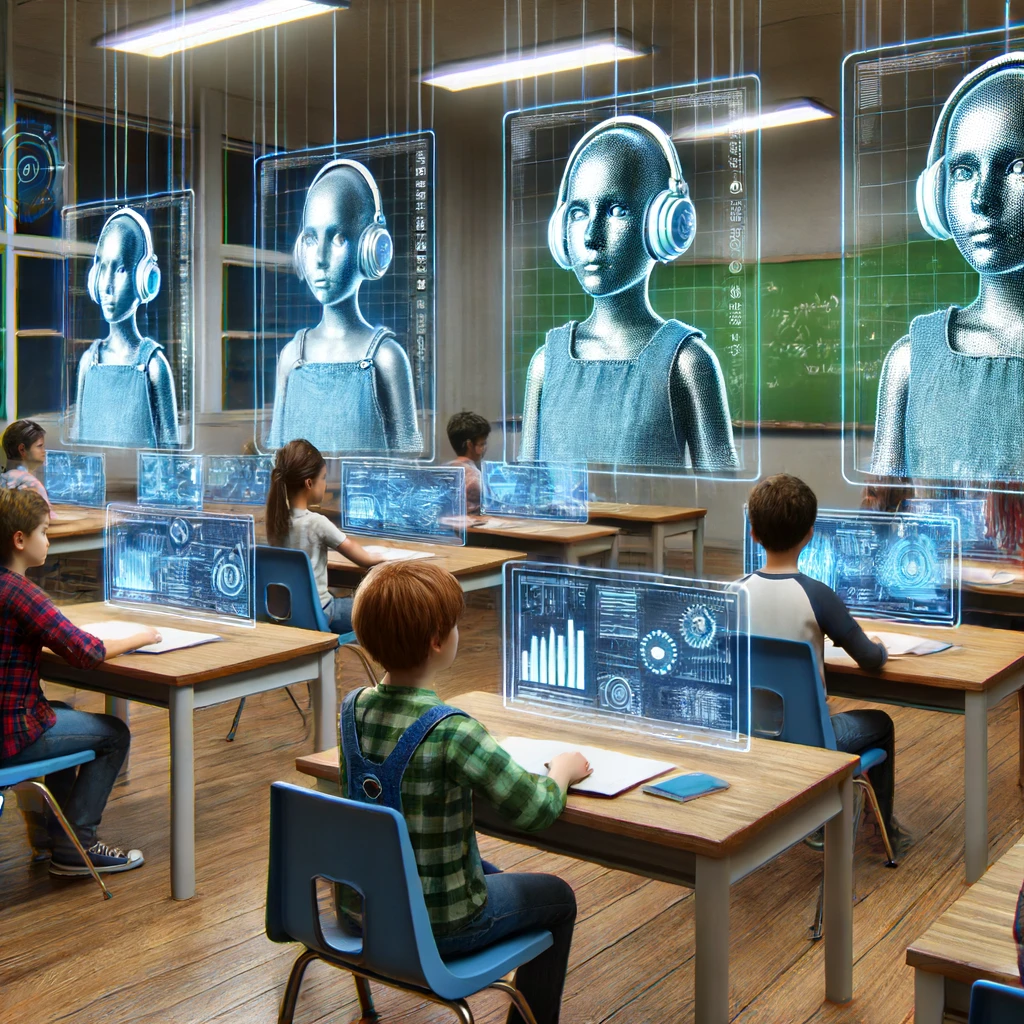

- Akademisk integritet: I utbildningssektorn används de för att förhindra fusk genom att identifiera uppsatser och andra uppgifter som kan ha skrivits av AI istället för av studenten själv.

- Journalistik och media: Med ökningen av AI-genererad nyhetsinnehåll och artiklar, hjälper AI Detectors redaktörer och läsare att säkerställa att informationen de konsumerar är autentisk och inte fabricerad.

- Sociala medier och onlineplattformar: För att motverka spridningen av desinformation och falska nyheter, används AI Detectors för att identifiera och flagga automatiskt genererat innehåll.

- Konsumentskydd: I kundservice och andra konsumentrelaterade områden kan AI Detectors säkerställa att interaktioner med chatbots och automatiska system är tydligt märkta, vilket hjälper kunder att veta när de interagerar med en maskin istället för en människa.

Jämförelse mellan AI-genererade texter och mänskligt skrivna texter

Nedan presenteras en detaljerad jämförelse mellan AI-genererade texter och mänskligt skrivna texter, där vi undersöker olika aspekter som ord- och meningslängd, grammatiska egenskaper, stilistiska variationer och mycket mer. Denna jämförelse belyser både styrkor och begränsningar hos AI-genererade texter jämfört med deras mänskliga motsvarigheter. På så vis kan du förstå hur AI Detectors fungerar och vad de letar efter för typer av mönster.

| Egenskap | AI-genererad text | Mänskligt skriven text |

|---|---|---|

| Genomsnittlig ordlängd | 4.5 bokstäver | 5.2 bokstäver |

| Genomsnittlig meningslängd | 12 ord | 18 ord |

| Grammatiska fel | Hög frekvens | Låg frekvens |

| Kontextuell relevans | Variabel | Hög |

| Användning av idiom | Ovanligt | Vanligt |

| Kreativitet och originalitet | Begränsad | Hög |

| Koherens i narrativ | Kan vara inkonsekvent | Generellt konsekvent |

| Variation i vokabulär | Begränsad | Rik och varierad |

| Ton och stil | Kan vara monotont | Varierande och dynamisk |

| Användning av metaforer | Sällsynt | Vanligt |

| Respons till frågor | Kan vara repetitiv | Vanligtvis unik |

| Förmåga att anpassa till kontext | Begränsad | Hög |

| Semantisk förståelse | Kan saknas djup | Djup och meningsfull |

| Korrekthet i fakta | Varierande | Generellt hög |

| Förmåga att improvisera | Begränsad | Hög |

| Emotionellt djup | Bristfälligt | Djupgående |

| Användning av specialiserade termer | Begränsad till träningens omfattning | Bredare och mer flexibel |

| Anpassning till publik | Generisk | Anpassad och specifik |

| Redundans i information | Hög | Låg |

| Temporala referenser | Kan vara inkonsekvent | Generellt konsekvent |

| Konsekvens i pronomenanvändning | Varierande | Konsistent |

| Humor och ironi | Ovanligt | Vanligt och varierande |

| Stilistisk variation | Begränsad | Rik och varierad |

| Förmåga att dra slutsatser | Begränsad | Hög |

| Kulturell relevans | Kan saknas | Generellt närvarande |

| Respons till ändringar i kontext | Begränsad | Dynamisk och anpassningsbar |

Historik och utveckling

Tidiga försök att upptäcka AI-genererad text

De tidigaste försöken att upptäcka AI-genererad text går tillbaka till de första användningarna av enkla AI-algoritmer för textgenerering. Initialt handlade det om att identifiera text skapad av regelbaserade system som ELIZA, ett tidigt datorprogram som simulerade konversationer med människor. Dessa system var relativt enkla att upptäcka på grund av deras begränsade ordförråd och upprepade mönster.

Med tiden blev AI-systemen mer sofistikerade. I slutet av 1990-talet och början av 2000-talet började forskare använda statistiska metoder och maskininlärning för att skapa mer avancerade textgenereringsmodeller. Försök att upptäcka AI-genererad text under denna period involverade ofta analys av grammatisk korrekthet, ordfrekvenser och andra statistiska egenskaper.

Tips: Vi har vår egen svenska AI Detektor som upptäcker om texten är mänsklig eller AI-skriven.

Viktiga milstolpar i utvecklingen av AI Detectors

- 2006 – Lansering av OpenAI GPT-1: Detta markerade en viktig milstolpe i utvecklingen av AI-genererade texter. Med introduktionen av transformer-modeller blev det möjligt att generera mer sammanhängande och mänskligt liknande texter. Detta ökade behovet av mer avancerade detekteringsmetoder.

- 2018 – OpenAI GPT-2: Med lanseringen av GPT-2 blev textgenerering ännu mer sofistikerad. Modellen kunde producera mycket övertygande text, vilket gjorde det svårare att skilja mellan mänskligt och AI-genererat innehåll. Detta ledde till utvecklingen av mer avancerade AI Detectors som kunde analysera kontext och koherens på djupare nivåer.

- 2019 – GLTR (Giant Language model Test Room): Ett verktyg utvecklat av MIT-IBM Watson AI Lab som använder statistiska analyser för att upptäcka AI-genererad text. GLTR analyserar sannolikhetsfördelningen av ord i en text och jämför den med förväntade mönster från mänskligt skrivande.

- 2020 – Launch of AI Text Classifiers: OpenAI och andra organisationer utvecklade specifika klassificeringsverktyg som kunde skilja mellan text genererad av deras modeller och mänskligt skrivna texter. Dessa verktyg använde djupinlärning och stora mängder träningsdata för att förbättra noggrannheten.

- 2021 – Integration av AI Detectors i populära plattformar: Plattformar som Turnitin började använda AI Detectors för att hjälpa utbildningsinstitutioner att upptäcka plagiat och AI-genererad text i studentuppsatser.

- 2023 – Förbättrade multimodala AI Detectors: Moderna AI Detectors började kombinera textanalys med bild- och ljudanalys för att identifiera AI-genererat innehåll i olika medier, vilket gjorde det möjligt att upptäcka mer komplexa former av automatiserat innehåll.

Dessa milstolpar representerar viktiga framsteg i både utvecklingen av AI-genererade texter och teknikerna för att upptäcka dem.

Hur AI Detectors fungerar

Teknologin bakom AI Detectors

AI Detectors använder en kombination av avancerade algoritmer och maskininlärningstekniker för att analysera och identifiera innehåll som har genererats av artificiell intelligens. Dessa teknologier är som sagt utformade för att upptäcka subtila mönster och anomalier som skiljer AI-genererad text från mänskligt skapad text.

De viktigaste teknologierna inkluderar:

- Maskininlärning (ML): Genom att träna modeller på stora mängder data kan AI Detectors lära sig att identifiera mönster som är typiska för AI-genererad text.

- Djupinlärning (Deep Learning): Använder neurala nätverk med flera lager för att analysera komplexa egenskaper i texten. Transformerbaserade modeller, såsom BERT och ChatGPT, är vanliga i detta sammanhang.

- Statistisk analys: Analyserar frekvenser och distributioner av ord och fraser för att upptäcka avvikelser från vad som förväntas i mänskligt skrivande.

- Natural Language Processing (NLP): Tekniker som möjliggör förståelse och bearbetning av naturligt språk, vilket gör det möjligt för AI Detectors att analysera textens struktur och grammatik.

- Syntaktisk och semantisk analys: Utvärderar textens syntaktiska struktur och semantiska koherens för att upptäcka mönster som är typiska för AI-genererad text.

Vanliga metoder och algoritmer som används

- Transformermodeller: Moderna AI Detectors använder transformerbaserade modeller som GPT (Generative Pre-trained Transformer) och BERT (Bidirectional Encoder Representations from Transformers). Dessa modeller kan generera mycket realistisk text, men de kan också tränas för att upptäcka AI-genererad text genom att identifiera specifika mönster.

- N-gram analys: En statistisk metod som analyserar sekvenser av ord (n-grams) i texten. AI-genererad text tenderar att ha olika n-gram distributioner jämfört med mänskligt skrivande.

- Frekvensanalys: Analyserar hur ofta specifika ord och fraser förekommer i texten. AI-genererad text kan ha onaturligt hög eller låg frekvens av vissa ord.

- Koherens och sammanhangsanalys: Utvärderar hur väl textens meningar och stycken hänger samman. AI-genererad text kan ibland vara grammatiskt korrekt men sakna djupare sammanhang och koherens.

- Stilometri: En metod för att analysera skrivstil genom att undersöka egenskaper som ordlängd, meningslängd och användning av skiljetecken. AI-genererad text kan ha en annan stilistisk signatur än mänskligt skrivande.

- Metadatabaserad analys: Utöver textinnehållet kan AI Detectors analysera metadata som genereringstid, redigeringshistorik och andra spår som kan indikera AI-användning.

- Hybridmodeller: Kombinerar flera metoder och algoritmer för att förbättra noggrannheten i detekteringen. Genom att använda både statistiska och djupinlärningsbaserade tekniker kan dessa modeller ge en mer robust analys.

Fördelar och nackdelar med AI Detectors

Fördelar

- Förbättrad akademisk integritet: AI Detectors hjälper skolor och universitet att säkerställa att studenternas arbete är autentiskt och inte genererat av AI, vilket upprätthåller utbildningskvaliteten.

- Skydd mot desinformation: Genom att identifiera AI-genererat innehåll kan AI Detectors bidra till att minska spridningen av falska nyheter och desinformation på sociala medier och andra plattformar.

- Ökad trovärdighet i journalistik: Med dessa detektorer kan nyhetsorganisationer säkerställa att deras innehåll är äkta, vilket ökar förtroendet bland läsarna.

- Transparent kundkommunikation: Företag kan använda AI Detectors för att informera kunder när de interagerar med AI-baserade kundtjänstsystem, vilket förbättrar kundupplevelsen.

- Etiska AI-praktiker: Genom att använda AI Detectors kan organisationer säkerställa att de följer etiska riktlinjer för användning av AI, vilket kan vara avgörande för deras rykte och förtroende.

Nackdelar

- Begränsad noggrannhet: De är inte alltid 100% korrekta och kan ibland felaktigt identifiera mänskligt skrivna texter som AI-genererade och vice versa.

- Integritetsfrågor: Analys av innehåll kan leda till integritetsproblem, särskilt om AI Detectors används utan användarnas medgivande eller om känsliga data analyseras.

- Höga kostnader: Utveckling och implementering av avancerade AI Detectors kan vara kostsamt, vilket kan vara en utmaning för mindre organisationer.

- Överdriven tillit: Överdriven tillit till detektorerna kan leda till att människor förlorar förmågan att kritiskt granska innehåll på egen hand.

Sålunda erbjuder AI Detectors många fördelar, särskilt inom områden som akademisk integritet och skydd mot desinformation. Dock finns det också betydande nackdelar och utmaningar som måste hanteras för att dessa verktyg ska användas på ett etiskt och effektivt sätt.

Hur de används inom sociala medier

- Moderering av innehåll: Sociala medieplattformar kan använda AI Detectors för att övervaka och moderera innehåll, identifiera AI-genererade inlägg och förhindra spridning av automatiserade bots och falska konton.

- Skydd mot desinformation: Plattformar kan använda AI Detectors för att upptäcka och flagga AI-genererat innehåll som sprider falsk information, vilket bidrar till att skydda användare från vilseledande eller skadligt innehåll.

- Transparens i reklam: AI Detectors kan användas för att granska och verifiera att annonser och sponsrade inlägg är skapade av människor och inte AI, vilket ökar transparensen och förtroendet bland användarna.

- Förbättring av användarupplevelse: Genom att identifiera och markera AI-genererat innehåll kan plattformar ge användarna möjlighet att välja bort eller specifikt söka efter AI-genererat material, vilket anpassar användarupplevelsen efter individuella preferenser.

Framtida utveckling

Potentiella förbättringar och innovationer

Förbättrad noggrannhet och precision

Framtida detektorer kommer sannolikt att bli ännu mer precisa och kunna skilja AI-genererat innehåll från mänskligt skrivet material med högre noggrannhet. Detta kan uppnås genom att använda större och mer varierade träningsdatamängder samt avancerade algoritmer.

Multimodal detektion

Utvecklingen av AI Detectors som kan analysera inte bara text, utan även bilder, videor och ljud. Detta skulle möjliggöra detektering av AI-genererat innehåll i en bredare mängd medier, vilket är särskilt viktigt för plattformar som hanterar multimedia-innehåll.

Realtidsdetektion

Implementering av realtids AI Detectors som kan analysera och identifiera AI-genererat innehåll direkt när det skapas eller delas. Detta skulle vara användbart för sociala medieplattformar och nyhetswebbplatser för att snabbt flagga och hantera potentiellt vilseledande innehåll.

Personalisering och användarvänlighet

Utveckling av detektorer som kan anpassas efter användarnas behov och preferenser. Till exempel, verktyg som ger användarna möjlighet att ställa in sina egna tröskelvärden för vad som anses vara AI-genererat innehåll.

Integrerad feedback-loop

AI Detectors som kontinuerligt lär sig och förbättras genom användarfeedback. Användare kan rapportera felaktigt identifierade texter, vilket gör det möjligt för systemen att justera och förbättra sin detektionsförmåga över tid.

Samarbete med plattformar

Bättre integration och samarbete mellan AI Detectors och populära plattformar som sociala medier, utbildningsverktyg och nyhetsaggregatorer för att säkerställa bredare användning och effektivare detektering.

Framtida trender och prognoser

- Ökad användning i utbildning: Som AI-genererade texter blir mer sofistikerade, kommer fler utbildningsinstitutioner att implementera AI Detectors för att upprätthålla akademisk integritet. Det förväntas också en ökad utbildning kring digital läskunnighet och kritisk källgranskning.

- Utveckling av regler och riktlinjer: Regeringar och internationella organisationer kan utveckla och införa regler och riktlinjer för användningen av detektorer för att säkerställa etiska och rättvisa tillämpningar, särskilt inom journalistik och media.

- Ethical AI Movement: En växande rörelse mot etisk AI kan leda till att AI Detectors blir standardverktyg i olika industrier för att säkerställa transparens och ansvarighet när AI används för att skapa innehåll.

- Globala samarbeten: Framtiden kan se fler globala samarbeten mellan forskningsinstitut, teknologiföretag och regeringar för att utveckla och implementera avancerade AI Detectors. Dessa samarbeten kan leda till standardiserade metoder och verktyg för AI-detektion.

- Teknologisk kapprustning: Det kommer sannolikt att pågå en ständig kapplöpning mellan utvecklingen av AI-genererade texter och AI Detectors. Som AI-modeller blir mer avancerade, kommer också detektorteknologin att behöva utvecklas för att hålla jämna steg.